ESXi 호스트의 어댑터 구성 프로세스에는 RDMA 네트워크 어댑터에 대한 VMkernel 바인딩을 설정한 다음, 소프트웨어 NVMe over RDMA 어댑터를 추가하는 작업이 포함됩니다. 그런 다음 NVMe 컨트롤러를 추가할 수 있습니다.

| 작업 | 설명 |

|---|---|

| RDMA 네트워크 어댑터 보기 | ESXi 호스트에서 RDMA(RoCE v2)를 지원하는 네트워크 어댑터를 설치합니다. 예: Mellanox Technologies MT27700 Family ConnectX-4. 네트워크 어댑터를 설치한 후 vSphere Client를 사용하여 RDMA 어댑터와 물리적 네트워크 어댑터를 검토합니다. |

| RDMA 어댑터에 대한 VMkernel 바인딩 구성 | NVMe over RDMA에 대한 포트 바인딩에는 스위치를 생성하고 물리적 네트워크 어댑터와 VMkernel 어댑터를 스위치에 연결하는 작업이 포함됩니다. 이 연결을 통해 RDMA 어댑터가 VMkernel 어댑터에 바인딩됩니다. 구성에서는 vSphere 표준 스위치 또는 vSphere Distributed Switch를 사용할 수 있습니다. |

| 소프트웨어 NVMe over RDMA 어댑터 추가 | vSphere Client를 사용하여 NVMe over RDMA에 대해 소프트웨어 스토리지 어댑터를 활성화합니다. |

| NVMe over Fabrics용 컨트롤러 추가 | vSphere Client를 사용하여 NVMe 컨트롤러를 추가합니다. 컨트롤러를 추가한 후에는 컨트롤러와 연결된 NVMe 네임스페이스를 ESXi 호스트에서 사용할 수 있게 됩니다. ESXi 환경의 네임스페이스를 나타내는 NVMe 스토리지 디바이스가 스토리지 디바이스 목록에 표시됩니다. |

다음 비디오는 NVMe over RDMA 어댑터를 구성하는 단계를 안내합니다.

RDMA 네트워크 어댑터 보기

ESXi 호스트에서 RDMA(RoCE v2)를 지원하는 네트워크 어댑터를 설치한 후 vSphere Client를 사용하여 RDMA 어댑터 및 물리적 네트워크 어댑터를 검토합니다.

프로시저

RDMA 어댑터에 대한 VMkernel 바인딩 구성

NVMe over RDMA에 대한 포트 바인딩에는 스위치를 생성하고 물리적 네트워크 어댑터와 VMkernel 어댑터를 스위치에 연결하는 작업이 포함됩니다. 이 연결을 통해 RDMA 어댑터가 VMkernel 어댑터에 바인딩됩니다. 구성에서는 vSphere 표준 스위치 또는 vSphere Distributed Switch를 사용할 수 있습니다.

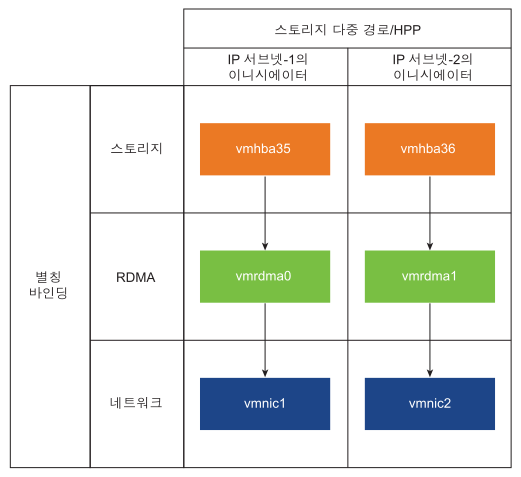

다음 다이어그램에는 NVMe over RDMA 어댑터에 대한 포트 바인딩이 표시됩니다.

스위치 생성에 대한 자세한 내용은 "vSphere 네트워킹" 설명서에서 "vSphere 표준 스위치 생성" 이나 "vSphere Distributed Switch 생성" 을 참조하십시오.

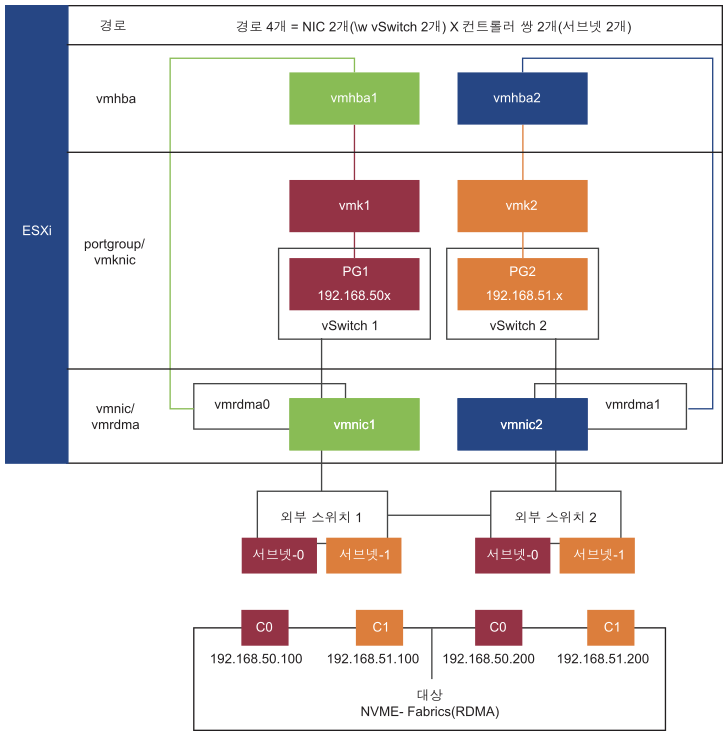

NVMe over RDMA를 사용하는 네트워크 토폴로지의 예

이 예에서는 vSphere 표준 스위치 2개와 업링크 2개(RDMA 지원 NIC)가 고가용성을 제공합니다. 2개의 서브넷에 있는 컨트롤러 쌍 2개에 연결됩니다.

여러 vSwitch 및 여러 업링크(RNIC)가 있는 HA

vSphere 표준 스위치를 사용하여 VMkernel 바인딩 구성

vSphere 표준 스위치 및 스위치당 하나의 업링크를 사용하여 RDMA 어댑터에 대한 VMkernel 포트 바인딩을 구성할 수 있습니다. 네트워크 연결을 구성하려면 각각의 물리적 네트워크 어댑터마다 가상의 VMkernel 어댑터를 생성해야 합니다. 각 가상 네트워크 어댑터와 물리적 네트워크 어댑터 간에 일대일 매핑을 사용합니다.

프로시저

- 네트워크 구성 요소 및 VMkernel 어댑터를 포함하는 vSphere 표준 스위치를 생성합니다.

- vSphere Client에서 호스트를 선택하고 네트워크 탭을 클릭합니다.

- 를 클릭합니다.

- VMkernel 네트워크 어댑터를 선택하고 다음을 클릭합니다.

- 새 표준 스위치를 선택하고 다음을 클릭합니다.

- 할당된 어댑터에서 +를 클릭합니다.

사용 가능한 물리적 어댑터 목록이 표시됩니다.

- 필요한 물리적 어댑터 vmnic를 선택하고 확인을 클릭합니다.

참고: RDMA 어댑터에 해당하는 물리적 네트워크 어댑터를 선택해야 합니다. RDMA 어댑터 vmrdma와 물리적 네트워크 어댑터 vmnic 간의 연결을 보려면 RDMA 네트워크 어댑터 보기 항목을 참조하십시오.

- VMkernel 포트 설정에서 필요한 값을 입력합니다.

스토리지 경로에 VLAN을 사용하는 경우 VLAN ID를 입력합니다.

- IP 설정 목록에서 VMkernel IPv4 설정을 입력합니다.

- 사용 가능한 서비스에서 NVMe over RDMA를 선택합니다.

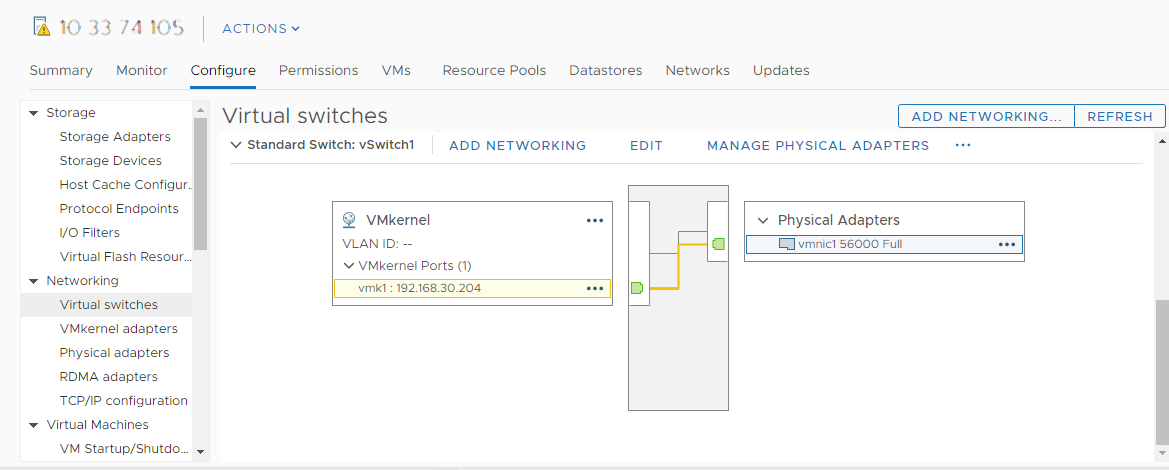

- 스위치가 올바르게 구성되었는지 확인합니다.

- 구성 탭의 네트워킹에서 가상 스위치를 선택합니다.

- 스위치를 확장하고 구성을 확인합니다.

이 그림에서는 물리적 네트워크 어댑터와 VMkernel 어댑터가 vSphere 표준 스위치에 연결되어 있음을 보여줍니다. 이 연결을 통해 RDMA 어댑터가 VMkernel 어댑터에 바인딩됩니다.

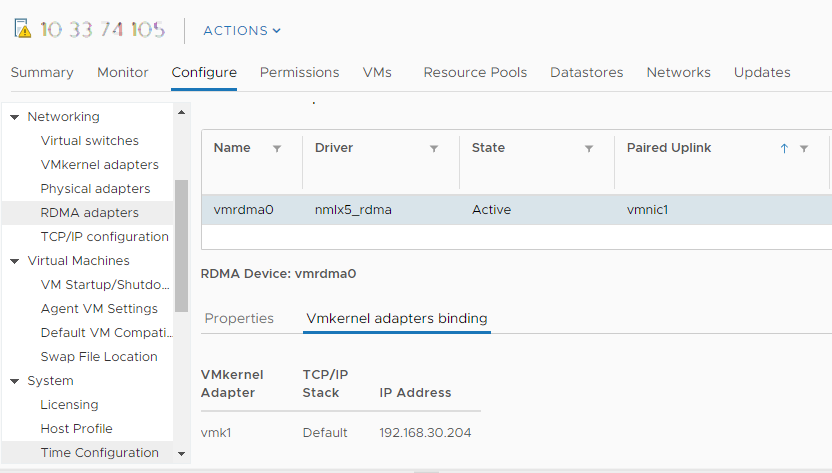

- RDMA 어댑터에 대한 VMkernel 바인딩의 구성을 확인합니다.

- 네트워킹 목록에서 RDMA 어댑터를 클릭하고 목록에서 RDMA 어댑터를 선택합니다.

- VMkernel 어댑터 바인딩 탭을 클릭하고 연결된 VMkernel 어댑터가 페이지에 나타나는지 확인합니다.

이 예에서 vmrdma0 RDMA 어댑터는 vmnic1 네트워크 어댑터와 쌍을 이루고 vmk1 VMkernel 어댑터에 연결됩니다.

vSphere 표준 스위치 및 NIC 팀 구성을 사용하여 VMkernel 바인딩 구성

NIC 팀 구성과 vSphere 표준 스위치를 사용하여 RDMA 어댑터에 대한 VMkernel 포트 바인딩을 구성할 수 있습니다. NIC 팀 구성을 사용하여 네트워크 이중화를 달성할 수 있습니다. 고가용성 및 로드 밸런싱을 위해 둘 이상의 NIC(네트워크 어댑터)를 하나의 팀으로 구성할 수 있습니다.

프로시저

vSphere Distributed Switch를 사용하여 VMkernel 바인딩 구성

vSphere Distributed Switch 및 스위치당 하나의 업링크를 사용하여 RDMA 어댑터에 대한 VMkernel 포트 바인딩을 구성할 수 있습니다. 네트워크 연결을 구성하려면 각각의 물리적 네트워크 어댑터마다 가상의 VMkernel 어댑터를 생성해야 합니다. 각 가상 네트워크 어댑터와 물리적 네트워크 어댑터 간에 일대일 매핑을 사용합니다.

프로시저

- VMkernel 어댑터 및 네트워크 구성 요소를 사용하여 vSphere Distributed Switch를 생성합니다.

- vSphere Client에서 데이터 센터를 선택하고 네트워크 탭을 클릭합니다.

- 작업을 클릭하고 를 선택합니다.

- 스위치의 이름을 선택합니다.

데이터 센터의 위치가 호스트 내에 있는지 확인하고 다음을 클릭합니다.

- 호환되는 ESXi 버전을 선택하고 다음을 클릭합니다.

- 필요한 업링크 수를 입력하고 마침을 클릭합니다.

- 분산 가상 스위치에 호스트를 하나 이상 추가합니다.

- vSphere Client에서 데이터 센터를 선택하고 Distributed Switch를 클릭합니다.

사용 가능한 DSwitch 목록이 표시됩니다.

- DSwitch를 마우스 오른쪽 버튼으로 클릭하고 메뉴에서 호스트 추가 및 관리를 선택합니다.

- 호스트 추가를 선택하고 다음을 클릭합니다.

- 호스트를 선택하고 다음을 클릭합니다.

- 업링크 할당을 선택합니다.

- vmnic를 할당할 관련 업링크를 입력합니다.

- VMkernel 어댑터를 할당하고 다음을 클릭합니다.

- vSphere Client에서 DSwitch를 선택하고 포트 탭을 클릭합니다.

여기에서 스위치에 대해 생성된 업링크를 볼 수 있습니다.

- vSphere Client에서 데이터 센터를 선택하고 Distributed Switch를 클릭합니다.

- NVMe over RDMA 스토리지 경로에 대한 분산 포트 그룹을 생성합니다.

- vSphere Client에서 필요한 DSwitch를 선택합니다.

- 작업을 클릭하고 을 선택합니다.

- 설정 구성에서 포트 그룹의 일반 속성을 입력합니다.

특정 VLAN을 구성한 경우 VLAN ID에 추가합니다.참고: VLAN을 올바르게 구성하지 않으면 네트워크 연결 문제가 발생할 수 있습니다.

- VMkernel 어댑터를 구성합니다.

- vSphere Client에서 DSwitch 목록을 확장하고 분산 포트 그룹을 선택합니다.

- 를 클릭합니다.

- 멤버 호스트 선택 대화 상자에서 호스트를 선택하고 확인을 클릭합니다.

- VMkernel 어댑터 구성 대화 상자에서 MTU가 스위치 MTU와 일치하는지 확인합니다.

- 사용 가능한 서비스에서 적절한 태그 지정에 대해 NVMe over RDMA를 선택합니다.

- 마침을 클릭합니다.

- 여러 RDMA 지원 NIC를 추가하려면 b 단계와 c 단계를 반복합니다.

- 분산 포트 그룹에 대한 NIC 팀 구성 정책을 설정합니다.

- 분산 포트 그룹에서 을 클릭합니다.

- 팀 구성 및 페일오버를 클릭하고 활성 업링크를 확인합니다.

- 업링크 하나는 포트 그룹에 대해 활성으로 할당하고 다른 업링크는 사용되지 않음으로 할당합니다.

생성된 각 포트 그룹에 대해 c 단계를 반복합니다.

다음에 수행할 작업

소프트웨어 NVMe over RDMA 또는 NVMe over TCP 어댑터 추가

ESXi는 NVMe over RDMA 및 NVMe over TCP 소프트웨어 어댑터를 지원합니다. vSphere Client를 사용하여 NVMe over RDMA 또는 NVMe over TCP에 대해 소프트웨어 스토리지 어댑터를 추가합니다.

사전 요구 사항

- ESXi 호스트에서 다음 유형의 스토리지를 지원하는 어댑터를 설치합니다.

- NVMe over RDMA 어댑터. 예: Mellanox Technologies MT27700 Family ConnectX-4.

- NVMe over TCP 어댑터. 예: i40en.

- 어댑터에 대한 VMkernel 바인딩을 구성합니다.

- NVMe over RDMA의 경우 RDMA 어댑터에 대한 VMkernel 바인딩 구성의 내용을 참조하십시오.

- NVMe over TCP의 경우 NVMe over TCP 어댑터에 대한 VMkernel 바인딩 구성의 내용을 참조하십시오.

프로시저

결과

NVMe over Fabrics용 컨트롤러 추가

vSphere Client를 사용하여 NVMe 컨트롤러를 추가합니다. 컨트롤러를 추가한 후에는 컨트롤러와 연결된 NVMe 네임스페이스를 ESXi 호스트에서 사용할 수 있게 됩니다. ESXi 환경의 네임스페이스를 나타내는 NVMe 스토리지 디바이스가 스토리지 디바이스 목록에 표시됩니다.

사전 요구 사항

- 스토리지 유형에 적합한 어댑터가 ESXi 호스트에 있는지 확인합니다. VMware NVMe 스토리지에 대한 요구 사항의 내용을 참조하십시오.

- NVMe over RDMA(RoCE v2) 스토리지를 사용하는 경우 다음 작업을 수행합니다.

- NVMe over TCP스토리지를 사용하는 경우 다음 작업을 수행합니다.

프로시저

- vSphere Client에서 ESXi 호스트로 이동합니다.

- 구성 탭을 클릭합니다.

- 스토리지 아래에서 스토리지 어댑터를 클릭하고 구성할 어댑터(vmhba#)를 선택합니다.

- 컨트롤러 탭을 클릭하고 컨트롤러 추가를 클릭합니다.

- 컨트롤러 추가 대화상자에서 다음 검색 방법 중 하나를 선택합니다.

옵션 설명 자동으로 이 옵션은 호스트가 컨트롤러를 자동으로 검색하고 사용 가능한 모든 컨트롤러에 대한 연결을 수락할 수 있음을 나타냅니다. - 컨트롤러를 검색할 수 있도록 다음 매개 변수를 지정합니다.

- NVMe over RDMA(RoCE v2)의 경우, IP 주소 및 전송 포트 번호

- NVMe over TCP의 경우 IP 주소, 전송 포트 번호 및 다이제스트 매개 변수.

- 컨트롤러 검색을 클릭합니다.

- 컨트롤러 목록에서 사용할 컨트롤러를 선택합니다.

수동으로 이 방법을 사용하면 컨트롤러 세부 정보를 수동으로 입력합니다. 지정한 매개 변수를 사용하여 호스트가 특정 컨트롤러에 대한 연결을 요청합니다. - 하위 시스템 NQN

- 대상 포트 ID.

- NVMe over RDMA(RoCE v2)의 경우, IP 주소 및 전송 포트 번호(선택 사항).

- NVMe over TCP의 경우 IP 주소, 전송 포트 번호(선택 사항) 및 다이제스트 매개 변수(선택 사항).

- NVMe over Fibre Channel의 경우 WorldWideNodeName 및 WorldWidePortName.

- 관리 대기열 크기. 컨트롤러의 관리 대기열 크기를 지정하는 선택적 매개 변수입니다. 기본값은 16입니다.

- Keepalive 시간 초과. 어댑터와 컨트롤러 사이의 연결 유지 시간 제한을 초 단위로 지정하는 선택적 매개 변수입니다. 기본 시간 초과 값은 60초입니다.

참고: IO 대기열 크기 및 IO 대기열 번호는 esxcli를 통해서만 설정할 수 있는 선택적 매개 변수입니다. - 컨트롤러를 검색할 수 있도록 다음 매개 변수를 지정합니다.

결과

컨트롤러가 컨트롤러 목록에 나타납니다. 이제 호스트가 컨트롤러와 연결된 NVMe 네임스페이스를 검색할 수 있습니다. ESXi 환경의 네임스페이스를 나타내는 NVMe 스토리지 디바이스가 vSphere Client의 스토리지 디바이스 목록에 표시됩니다.

![RDMA 어댑터가 목록에 vmrdma0으로 나타납니다. [연결된 업링크] 열에 네트워크 구성 요소가 vmnic1로 표시됩니다.](images/GUID-583E7E12-0BE6-44B4-A3A1-9EA4F7FB1BE8-low.png)