vSphere IaaS control plane 環境内の ESXi ホストに NVIDIA GRID GPU グラフィック デバイスが 1 つ以上搭載されている場合は、NVIDIA GRID 仮想 GPU (vGPU) テクノロジーを使用するように仮想マシンを構成できます。パススルー モードで仮想マシンを使用できるように ESXi ホスト上の他の PCI デバイスを構成することもできます。

vSphere IaaS control plane での vGPU を使用した仮想マシンのデプロイ

NVIDIA GRID GPU グラフィック デバイスは、複雑なグラフィック操作を最適化し、CPU に過大な負荷をかけずに高パフォーマンスで動作するように設計されています。NVIDIA GRID vGPU は、単一の物理 GPU を個別の vGPU 対応パススルー デバイスとして複数の仮想マシンで共有することにより、比類のないグラフィック パフォーマンス、費用対効果、およびスケーラビリティを提供します。

考慮事項

- 3 ゾーン スーパーバイザー は、vGPU を使用する仮想マシンをサポートしていません。

- 仮想マシン サービスで管理される vGPU デバイスを備えた仮想マシンは、ESXi ホストがメンテナンス モードになると自動的にパワーオフされます。このことが、仮想マシンで実行されているワークロードに一時的に影響する可能性があります。ホストがメンテナンス モードを終了すると、仮想マシンは自動的にパワーオンされます。

- DRS は、vGPU 仮想マシンを幅優先方式でクラスタのホスト全体に分散します。詳細については、『vSphere のリソース管理』ガイドの「DRS Placement of vGPU VMs」を参照してください。

要件

NVIDIA vGPU を構成するには、次の要件に従います。

- ESXi がサポートされていることを VMware 互換性ガイドで確認した後、ホストが電源および構成の要件を満たしていることをベンダーに問い合わせて確認します。

- [直接共有] モードの 1 つ以上のデバイスを使用するように ESXi ホストのグラフィック設定を構成します。『vSphere のリソース管理』ドキュメントのホスト グラフィックの構成を参照してください。

- vGPU デバイスを含む仮想マシンに対して使用するコンテンツ ライブラリには、起動モードが EFI に設定されたイメージ(CentOS など)が含まれている必要があります。

- NVIDIA vGPU ソフトウェアをインストールします。NVIDIA は、次のコンポーネントを含む vGPU ソフトウェア パッケージを提供します。

詳細については、該当する NVIDIA 仮想 GPU ソフトウェア ドキュメントを参照してください。

- vSphere 管理者が ESXi ホストにインストールする vGPU マネージャ。VMware のナレッジベースの記事KB2033434を参照してください。

- 仮想マシンのデプロイおよび起動後に DevOps エンジニアが仮想マシンにインストールするゲスト仮想マシン ドライバ。vSphere IaaS control plane の仮想マシンへの NVIDIA ゲスト ドライバのインストールを参照してください。

vSphere Client を使用した仮想マシン クラスへの vGPU デバイスの追加

仮想マシン クラスを作成、または既存の仮想マシン クラスを編集して、NVIDIA GRID 仮想 GPU (vGPU) を追加します。

前提条件

手順

結果

データセンター CLI を使用した仮想マシン クラスへの vGPU デバイスの追加

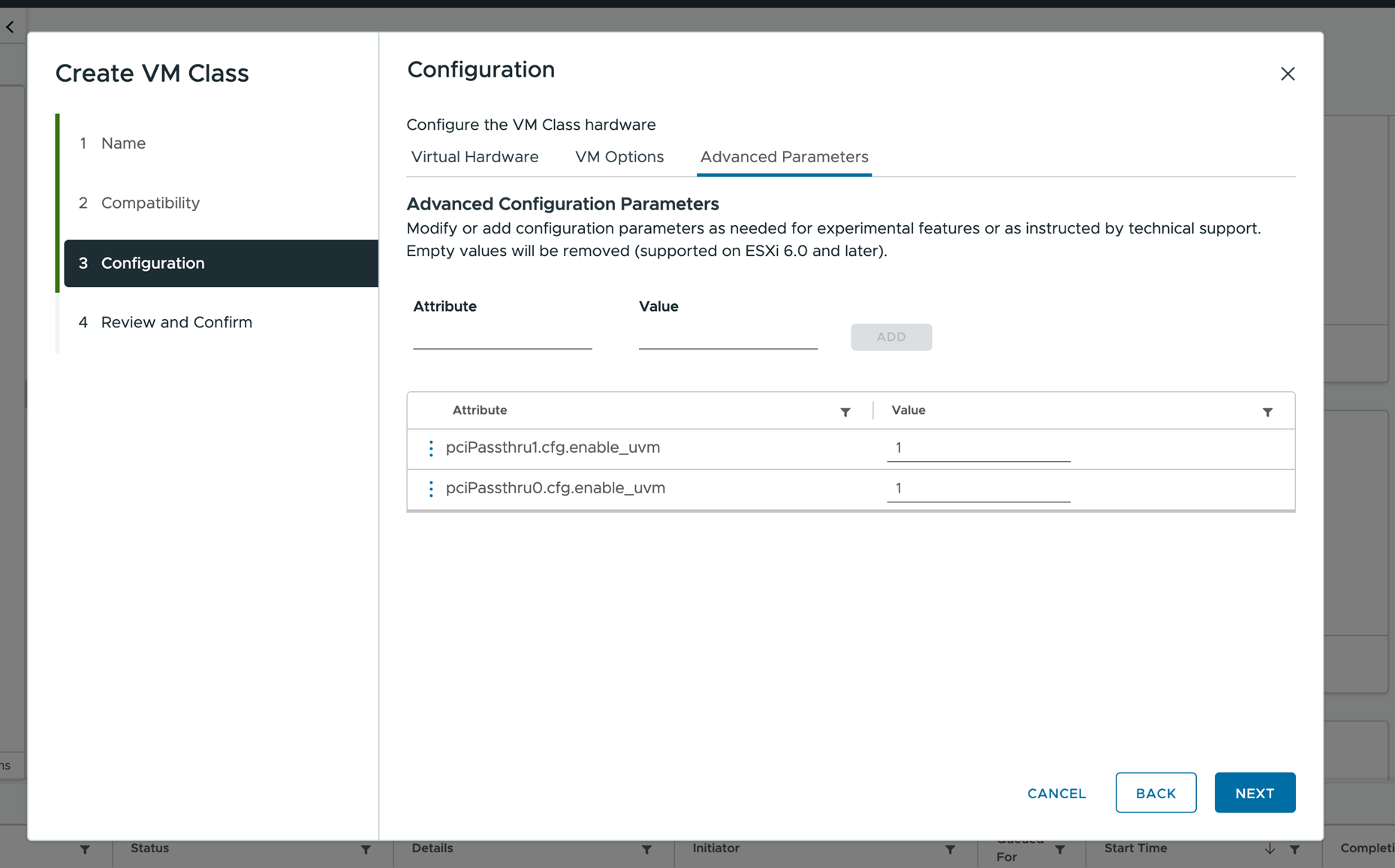

vGPU と詳細構成の追加には、vSphere Client に加え、データセンター CLI (DCLI) コマンドを使用することもできます。

DCLI コマンドの詳細については、「Data Center CLI を使用した仮想マシン クラスの作成と管理」を参照してください。

手順

vSphere IaaS control plane の仮想マシンへの NVIDIA ゲスト ドライバのインストール

仮想マシンに vGPU 用に構成された PCI デバイスが含まれている場合は、vSphere IaaS control plane 環境で仮想マシンを作成して起動した後、NVIDIA vGPU グラフィック ドライバをインストールして GPU 操作を完全に有効にします。

前提条件

- vGPU を備えた仮想マシンをデプロイします。仮想マシンの YAML ファイルが、vGPU 定義を持つ仮想マシン クラスを参照していることを確認します。vSphere IaaS control plane への仮想マシンのデプロイを参照してください。

- NVIDIA ダウンロード サイトから vGPU ソフトウェア パッケージをダウンロードし、パッケージを解凍し、ゲスト ドライブ コンポーネントの準備ができていることを確認します。詳細については、該当する NVIDIA 仮想 GPU ソフトウェアのドキュメントを参照してください。

注: ドライバ コンポーネントのバージョンは、vSphere 管理者が ESXi ホストにインストールした vGPU Manager のバージョンに対応している必要があります。

手順

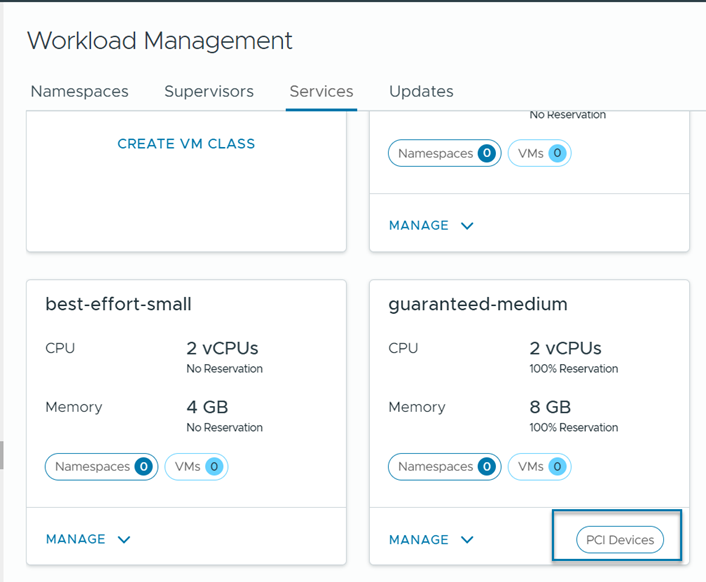

vSphere IaaS control plane での PCI デバイスを使用した仮想マシンのデプロイ

パススルー モードで仮想マシンを使用できるように、vGPU に加えて ESXi ホスト上の他の PCI デバイスを構成することもできます。

![[新しいデバイスを追加] メニューの [PCI デバイス] オプション](images/GUID-21E14AD3-806E-4965-90E8-8E821B6EB28F-low.png)